学习如何使用Hadoop生态系统关键性技术来导入并处理数据。

在为期4天的培训中,学员将学习关键概念和掌握使用新技术和工具将数据采集到Hadoop集群并进行处理。通过学习掌握诸如Spark(包括SparkStreaming和SparkSQL)、Flume、Kafka以及Sqoop这样的Hadoop生态系统工具和技术,Hadoop开发员将具备解决实际大数据问题和挑战的能力。使用Spark,不同行业的开发人员可以为不同的商业应用和系统架构编写复杂的并行应用,得以更快速地获取更优的商业决策,帮助决策人员进行及时应对。 一.培训内容 ● 通过讲师在课堂上的讲解,以及实操练习,学员将学习以下内容: ● 在Hadoop集群上进行分布式存储和处理数据。 ● 通过在Hadoop集群上编写、配置和部署ApacheSpark应用。 ● 使用Sparkshell进行交互式数据分析。 ● 使用SparkSQL查询处理结构化数据。 ● 使用SparkStreaming处理流式数据。 ● 使用Flume和Kafka为SparkStreaming采集流式数据。 二.培训对象及学员基础 ● 本课程适合于具有编程经验的开发员及工程师。无需ApacheHadoop基础。 ● 培训内容中对ApacheSpark的介绍所涉及的代码及练习使用Scala和Python,因此需至少掌握这两个编程语言中的一种。 ● 需熟练掌握Linux命令行。 ● 对SQL有基本了解。 三.课程大纲 1. Hadoop及生态系统介绍 ● ApacheHadoop概述 ● 数据存储和摄取 ● 数据处理 ● 数据分析和探索 ● 其他生态系统工具 ● 练习环境及分析应用场景介绍 2. ApacheHadoop文件存储 ● 传统大规模系统的问题 ● HDFS体系结构 ● 使用HDFS ● ApacheHadoop文件格式 3. ApacheHadoop集群上的数据处理 ● YARN体系结构 ● 使用YARN 4. 使用ApacheSqoop导入关系数据 ● Sqoop简介 ● 数据导入 ● 导入的文件选项 ● 数据导出 5. ApacheSpark基础 ● 什么是ApacheSpark ● 使用SparkShell ● RDDs(可恢复的分布式数据集) ● Spark里的函数式编程 6. SparkRDD ● 创建RDD ● 其他一般性RDD操作 7. 使用键值对RDD ● 键值对RDD ● MapReduce ● 其他键值对RDD操作 8. 编写和运行ApacheSpark应用 ● Spark应用对比SparkShell ● 创建SparkContext ● 创建Spark应用(Scala和Java) ● 运行Spark应用 ● Spark应用WebUI 9. 配置ApacheSpark应用 ● 配置Spark属性 ● 运行日志 10. ApacheSpark的并行处理 ● 回顾:集群环境里的Spark ● RDD分区 ● 基于文件RDD的分区 ● HDFS和本地化数据 ● 执行并行操作 ● 执行阶段及任务 11. Spark持久化 ● RDD演变族谱 ● RDD持久化简介 ● 分布式持久化 12. ApacheSpark数据处理的常见模式 ● 常见Spark应用案例 ● 迭代式算法 ● 机器学习 ● 例子:K-Means 13. DataFrames和SparkSQL ● ApacheSparkSQL和SQLContext ● 创建DataFrames ● 变更及查询DataFrames ● 保存DataFrames ● DataFrames和RDD ● SparkSQL对比Impala和Hive-on-Spark ● Spark2.x版本上的ApacheSparkSQL 14. ApacheKafka ● 什么是ApacheKafka ● ApacheKafka概述 ● 如何扩展ApacheKafka ● ApacheKafka集群架构 ● ApacheKafka命令行工具 15. 使用ApacheFlume采集实时数据 ● 什么是ApacheFlume ● Flume基本体系结构 ● Flume源 ● Flume槽 ● Flume通道 ● Flume配置 16. 集成ApacheFlume和ApacheKafka ● 概要 ● 应用案例 ● 配置 17. ApacheSparkStreaming:DStreams介绍 ● ApacheSparkStreaming概述 ● 例子:Streaming访问计数 ● DStreams ● 开发Streaming应用 18. ApacheSparkStreaming:批处理 ● 批处理操作 ● 时间分片 ● 状态操作 ● 滑动窗口操作 19. ApacheSparkStreaming:数据源 ● Streaming数据源概述 ● ApacheFlume和ApacheKafka数据源 ● 例子:使用Direct模式连接Kafka数据源 20. 结论

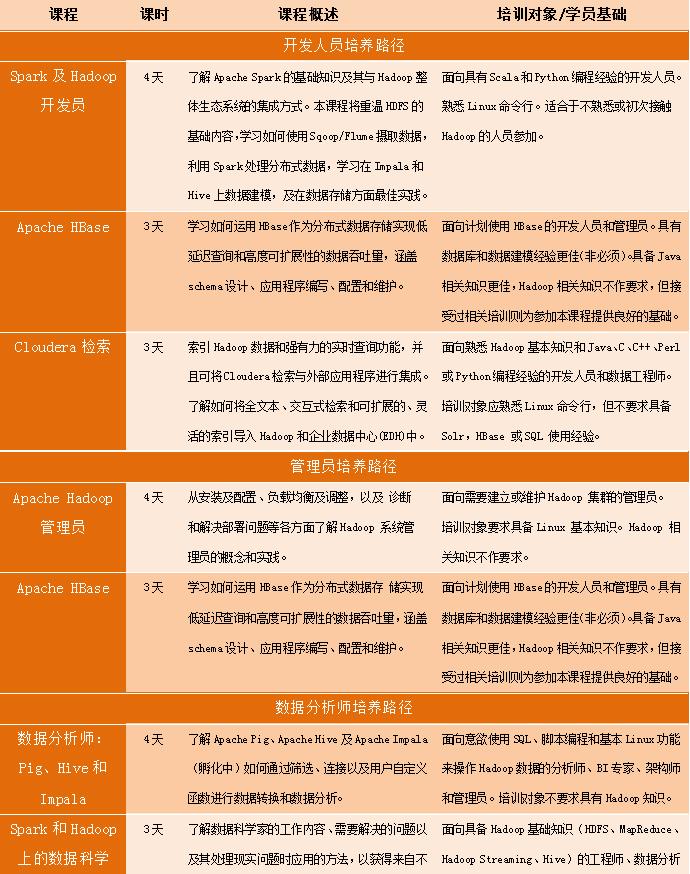

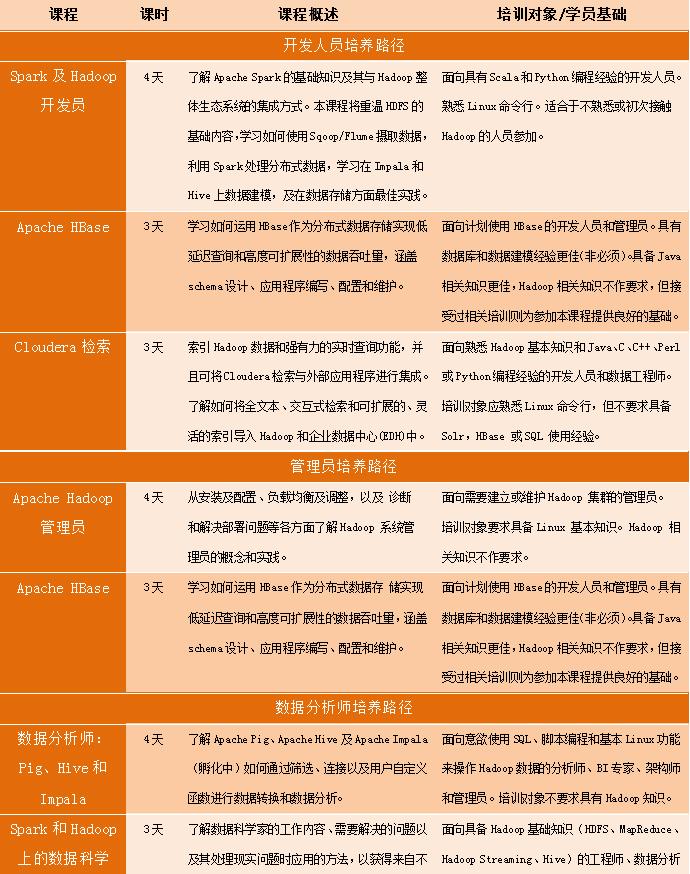

Cloudera大数据课程体系

十七年老品牌

十七年老品牌